Cette newsletter est co-écrite par Philippe NIEUWBOURG ( Decideo ), Julien Soulard ( smartcockpit ) et Estelle Riboni-Cordelier ( OXIBI SA )

Shadow AI, un virus qui a envahi votre entreprise, et expose parfois certaines informations confidentielles

“On va trouver une solution…”, une des pires phrases, entendue pourtant fréquemment dans les bureaux, loin des oreilles du service informatique. Cette “solution” consiste en réalité à contourner les règles mises en place par le département informatique, et à installer soi-même un logiciel, ou à faire appel à un service extérieur… alors que l’on ne devrait pas. C’est ce que l’on appelle le “shadow IT”. Et dans cette histoire, finalement tout le monde a ses raisons… mais les risques encourus sont importants.

Les départements métier ont raison : ils ont besoin d’une solution, rapidement, efficacement, agilement pourrait-on dire ; et ils n’ont pas toujours pu anticiper ce besoin, descendant parfois d’une décision prise au niveau supérieur. “Je dois réaliser telle analyse, collecter telle donnée… et je dois fournir les résultats pour lundi…” Peut-on le leur reprocher ? La plupart du temps, non. Même si parfois l’anticipation aurait cependant été possible, si l’on avait pris le temps d’exprimer ses propres besoins futurs.

Le département informatique a raison : sa responsabilité est de préserver l’intégrité, la sécurité, la confidentialité du système d’information. Il ne peut autoriser une application sans s’être assuré au préalable de sa sécurité pour l’ensemble de l’infrastructure de l’entreprise. Il est épaulé dans cette démarche par la règlementation, normes Cybersecurity Act, RGPD, AI Act et autres règles.

Donc tout le monde a raison… et l’on ne cherche d’ailleurs pas un coupable.

Mais il nous semble que la sécurité de l’entreprise prime, ce que tout dirigeant est capable de comprendre. Il est donc bien souvent interdit d’installer une application qui n’ait pas été validée préalablement par le service informatique, et interdit de transférer des données dans le cloud, au travers d’une application SaaS, sans que le service informatique, et parfois le DPO s’il s’agit de données personnelles, n’ait pu s’assurer de son innocuité. Pourtant on retrouve encore sur des ordinateurs, des applications installées sans autorisation, des services SaaS dont les abonnements sont mis en note de frais, et parfois ils peuvent avoir eu accès à des données confidentielles.

En matière d’intelligence artificielle, c’est exactement la même chose… en pire !

La découverte à titre personnel des IA génératives publiques en 2022 (dont le devenu fameux ChatGPT), a pu donner l’impression que leur usage dans le monde professionnel était aussi simple que dans la sphère privée. Cela démontre surtout une méconnaissance du mode de fonctionnement de ces outils.

Imaginez un instant que vous achetiez une voiture, et que vous découvriez que toutes les conversations qui se tiennent à l’intérieur sont enregistrées, envoyées vers le cloud, et partagées avec le constructeur ! Achèteriez-vous cette voiture ? Sans doute pas.

Or c’est ce qu’il se passe lorsque vous demandez à une IA générative publique de rédiger un compte-rendu de réunion, ou de résumer un document confidentiel que vous auriez préparé. Tout cela est conservé et analysé par l’IA que vous invoquez. IA publique, IA privée, RAG… Cela semble bien compliqué, et les utilisateurs n’ont pas conscience des conséquences d’un usage dont ils voient seulement le côté pratique.

La plupart des entreprises n’a pas encore mis en place de code de conduite concernant ces usages de l’IA ; les salariés ne savent donc pas vraiment ce qu’ils peuvent faire ou pas. Et dans le doute, c’est comme pour la dissertation de votre adolescent, on demande un coup de main à ChatGPT !

Mais dans l’entreprise, les conséquences peuvent être gravissimes. Surtout si l’usage de l’IA par certains salariés se fait de manière occulte, le “shadow AI”. Souvent de bonne foi, les usagers n’ont pas connaissance du code de conduite et des interdictions qui vont avec ; parfois, ils croient que cela ne concerne que leur poste de travail dans l’entreprise, chargent les données sur une clef USB, et nourrissent ChatGPT depuis l’ordinateur de la maison ! Que ne ferait-on pas pour économiser un peu de temps ?

Les conséquences de ce shadow AI sont entre autres :

- Le risque de voir des données confidentielles, mentionnant des projets clients, des caractéristiques de produits non encore annoncés, des stratégies, rejoindre les bases de connaissances d’une IA publique, et par la suite apparaitre dans les résultats générés pour un concurrent ;

- Le risque de voir des données personnelles, normalement protégées par le RGPD ou la LPD, également être intégrées dans une IA publique ;

- Le risque d’hallucinations, de biais ou de discriminations si les résultats obtenus ne sont pas vérifiés par l’utilisateur, entrainant de mauvaises décisions.

Plusieurs mesures concrètes doivent être déployées :

- La rédaction d’une charte et d’un code de conduite, compréhensible, expliqué, précis et assorti de sanctions éventuelles en cas de non-respect ;

- La diffusion non-équivoque de ce code de conduite auprès de l’ensemble des employés et sous-traitants, en s’assurant de leur bonne information, et en les responsabilisant par une signature les engageant ;

- Mais également (qui aurait cru que nous oserions le citer dans un document professionnel !), pour paraphraser Vladimir Lénine qui aurait expliqué que “la confiance n’excluait pas le contrôle”, la mise en place de tableaux de bord permettant de piloter les usages autorisés, et de détecter en partie les usages cachés.

Voici les sujets que nous allons aborder dans les différents articles de cette newsletter. Nous commençons aujourd’hui par le constat et les premières solutions. Dans les prochains articles, nous continuerons de faire le tour de ce sujet, afin de vous donner les clefs nécessaires à la préhension d’une bonne gouvernance de vos projets d’intelligence artificielle.

Parfois sans le savoir, vous partagez des informations sensibles et confidentielles sur vos projets, vos clients, ou des données personnelles

Aujourd’hui on ne compte plus le nombre d’employés reconnaissant copier et coller des informations sensibles dans un outil d’IA Générative ; Combien sont-ils à le faire de manière hebdomadaire ? Sous couvert d’efficacité, ils se retrouvent à coller des données financières, personnelles, des projets confidentiels ou du code source exposant ainsi des données cruciales à des outils d’IA Générative publique. Les employés placent sans s’en rendre compte la productivité avant la confidentialité, générant des risques que l’entreprise ne soupçonnait pas jusqu’ici et auxquels on peine à répondre. Soyons francs, la méconnaissance des directions générales les conduit elles-mêmes parfois à exiger la productivité au détriment de la sécurité. L’éducation de tous reste à faire ! Et les directions générales ne sont d’ailleurs pas les dernières à procéder ainsi et à exposer leurs propres données !

L’IA nous fait gagner du temps et produit une perception d’efficacité ; Plutôt que de lire le rapport financier d’une entreprise qui occupe plusieurs pages, qui ne serait pas tenté de demander à ChatGPT d’en faire un résumé ou d’en établir une synthèse plus digeste ?

Et qu’en est-il du médecin qui n’a pas le temps de lire une étude médicale sur un nouveau traitement ? Il soumet alors l’étude à l’IA pour qu’elle la lui résume, transmettant ainsi les données des patients, et des informations protégées par le secret professionnel, dans Co-Pilot.

On crie au scandale et cela semble impensable que l’on expose ainsi des données personnelles, et pourtant cela se produit quotidiennement, y compris dans votre entreprise. L’IA générative nous expose plus ouvertement aux fuites de données, violations des règles RGPD ou LPD, partages de données confidentielles ou secrètes. Les retombées peuvent être désastreuses… nous exposant au paradoxe du but initial : utiliser ces IA génératives pour augmenter la productivité et l’efficience sur les tâches répétitives ou chronophages.

On dit qu’il n’y a pas de fumée sans feu… et bien il n’y pas d’IA sans données ! La clef de la sécurité de vos données réside donc dans leur gouvernance et dans celles de vos projets d’IA .

Les risques liés à une confiance trop importante en l’IA

La divulgation d’informations n’est pas le seul risque de l’utilisation de l’IA Générative… le contenu généré par ces outils comporte lui aussi ses propres risques. Il y a quelques mois, un avocat américain, sans doute trop confiant, a demandé à une IA publique de rédiger sa prochaine plaidoirie, en incluant des références à de la jurisprudence. Docile, l’IA a rédigé la plaidoirie, mais l’a truffée de jurisprudences inventées ! L’avocat n’a pas relu. Mais le juge s’en est aperçu. Sans doute l’avocat ne confiera-t-il plus à une IA ses plaidoiries sans les vérifier !

Un autre exemple, un responsable du risque demande à l’IA un rapport financier sur l’un de ses créditeurs. L’IA lui retourne un document cohérent avec des chiffres concernant le bilan financier. Le gestionnaire s’interrogeant sur les chiffres retournés, découvre que ceux-ci sont faux… L’IA les a inventés pour créer un document cohérent et complet. Les IA génératives sont les reines du “plausible”; mais la notion de “vrai” ou de “faux” leur est structurellement inconnue. Par ailleurs, la plupart ne savent pas répondre “je ne sais pas…”.

Faut-il douter des réponses des IA? Certainement ! Le but de l’IA générative est de générer du contenu, la véracité et la fiabilité de ce qu’elle retourne peut varier, les réponses sont sujettes aux hallucinations, aux biais ou aux omissions. Nous définirons tout cela dans un prochain article.

Ne prenez pas pour argent comptant ce que ces outils retournent ! Gardez votre esprit critique et vérifiez les informations.

L’utilisation de l’IA dans le monde du travail soulève bien des risques, de la transmission de données à l’IA Générative, jusqu’à l’utilisation d’informations erronées retournées par ces mêmes IA dans notre travail. De quels risques parle-t-on ? Risque de réputation, risque financier, risque stratégique, risque légal, risque commercial parfois.

Connaissez-vous vos données sensibles et à risque ? Un petit rappel concernant les classifications des données et leurs catégorisations, elles sont essentielles à la compréhension de ce que l’on peut divulguer ou non à l’extérieur de l’entreprise. Selon la branche dans laquelle opère votre entreprise, utilisez un standard qui convienne à vos types de données : santé, banque et finance, ressources humaines, éducation, industrie. Il y a plusieurs standards et framework selon le type de données : ISACA, ISO 27001, NIST 800-53, CIS controls, HIPAA (Health Insurance Portability and Accountability Act), GLBA (Gramm-Leach-Bliley Act)

Cartographiez vos risques et classez-les dans une matrice, vous permettant ensuite de les mitiger. Là encore, nous détaillerons le sujet dans un des prochains articles, pour vous permettre de regrouper tout cela dans un cockpit de pilotage.

La question est donc : comment prémunir son entreprise contre la mauvaise utilisation des outils d’IA générative ? Il faut y aller par étape, et élargir sa vision petit à petit. Les phases clefs pour mitiger vos risques, que vous retrouverez dans la majorité des frameworks sont l’acculturation, la sécurité des données, la transparence.

“Je ne savais pas…”, voici une phrase que l’on ne devrait plus employer en entreprise concernant la fuite de données. La sensibilisation, ou acculturation, lors de l’usage des outils d’IA est devenu primordiale, tant sur les risques encourus lors de la transmission à l’IA que sur les réponses qu’elle nous retourne.

Nous nous rendons compte aujourd’hui de l’impératif d’accompagnement et d’encadrement de l’utilisation de l’IA en entreprise. Il faut procéder par étapes : commencez par établir les règles d’utilisation de l’IA dans votre entreprise, et propage votre code des bonnes pratiques. L’acculturation, la transparence … que peut-on faire et ne pas faire avec les IA publiques. Etablissez des règles claires d’utilisation des systèmes de l’IA, votre entreprise et son avenir, vous en seront reconnaissants.

Sans oublier la protection des données et dans certains cas les restrictions d’utilisations. De la même manière que lorsque vous donnez un téléphone à l’un de vos enfants : vous le lui confiez avec des règles d’utilisation, lui expliquez les risques encourus sur certaines applications et vous fixez des restrictions. Il en est de même pour l’utilisation de l’IA Générative. En entreprise il est toutefois important que ces mitigations ne restreignent pas les initiatives des collaborateurs à utiliser l’IA à des fins de simplification, de performance, ou d’innovation. Tout est une question de balance, de juste milieu à trouver. Ce secteur est en pleine évolution, tout comme ses usages. A nous de trouver la bonne forme de gouvernance, et de pilotage.

Comment détecter et encadrer le shadow AI

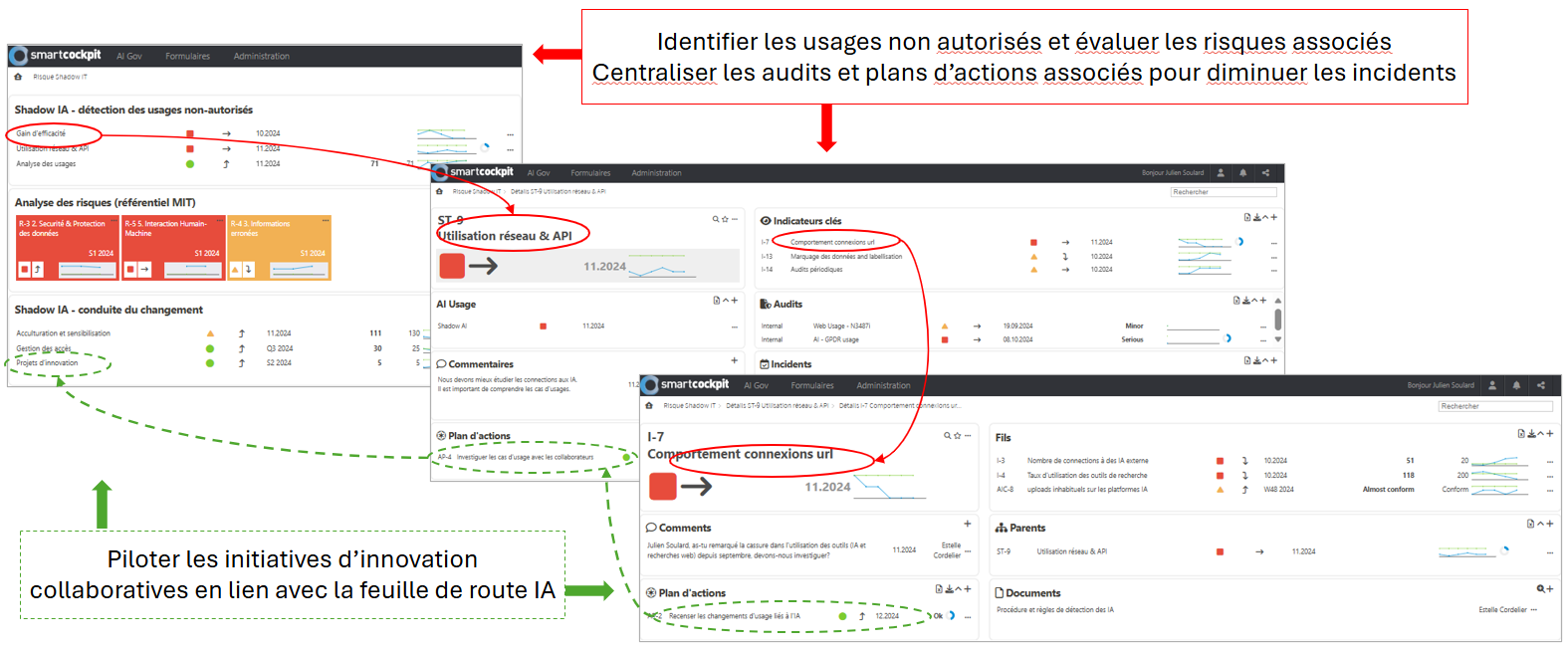

Ce qui n’est pas visible ne peut être encadré ou accompagné. L’enjeu est donc de pouvoir identifier les usages non autorisés grâce à des outils externes.

Une fois ces usages identifiés, il ne faut pas être dans le “tout répressif”. Si les usages n’ont pas eu de conséquence, il faut savoir le cas échéant saluer la prise d’initiative tout en rappelant les risques encourus et les règles de l’entreprise. Et même parfois modifier les règles en conséquence.

Comment détecter ces usages “hors du cadre” ?

Nous proposons ici quelques « signaux » à observer :

- Des gains de temps inhabituels ou bien des écarts importants entre collaborateurs sur le traitement de tâches qui peuvent s’appuyer sur de l’IA (ex.: rédaction de rapports, réalisation d’analyses)

- Des changements de pratiques marquants dans la formalisation de documents, qui pourraient sous-entendre l’utilisation de génération d’images ou du formatage de texte

- Des connexions url externes sur des moteurs de recherche traditionnels en forte baisse (et surement une forte hausse sur les IA publiques en parallèle) doivent attirer l’attention. Ou bien encore une baisse des requêtes sur PC (au profit de connexions en hausse sur les smartphones…) peut susciter des questions.

Ces initiatives personnelles peuvent néanmoins révéler des besoins d’efficience ou d’amélioration des conditions de travail de la part des collaborateurs, dont l’entreprise doit tenir compte et auxquels elle doit amener des réponses. Ces « signaux » doivent être recensés, objectivés dans la mesure du possible par des indicateurs, et suivis de plans d’actions, l’ensemble étant regroupé dans un cockpit dédié, comme celui que vous retrouverez ci-dessous en illustration.

En outre, les collaborateurs sont souvent les mieux placés pour imaginer de nouvelles approches répondant à leurs besoins ou à ceux de leurs clients. Il peut être donc judicieux de mettre en avant les bonnes idées, qui pourront dans certains cas amener à confier à ces collaborateurs des projets IA encadrés et financés, ce qui peut contribuer à développer ainsi une innovation maîtrisée. Le cockpit peut d’ailleurs lui-même servir à remonter ces suggestions.

Mais tout cela, disons-le en un mot, dans un cadre de “gouvernance”, suivi au travers d’un poste de pilotage. C’est le thème de cette newsletter que nous développerons plus en détail dans les prochaines semaines.